从一个法律案件,分析个人声音被盗的途径

随着AI技术的普及,只要提取一个人足够的声音样本,就能“克隆”出他的声音,制作出AI人声产品。技术的更新也给声音权益的保护带来挑战。

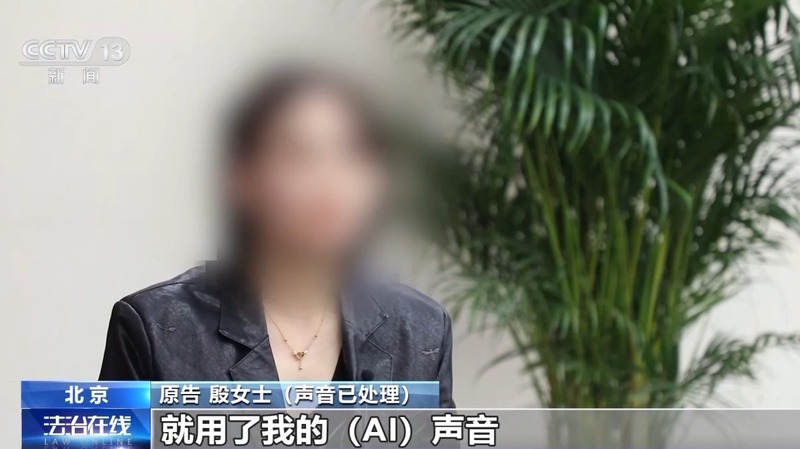

在北京互联网法院一审宣判的全国首例AI声音侵权案,引发了社会各界对AI技术应用边界的广泛关注。本案涉及AI声音的样本原型殷女士,她的声音在未经授权的情况下被克隆并商业化。

一个声音被克隆的法律案件

殷女士是一名专业的配音师,她发现自己的声音被用于短视频平台的AI配音,而她从未授权任何个人或公司将其声音AI化。经过调查,殷女士发现,她的声音是通过与一家文化传媒公司的合作中被录音制品化,而后未经她同意,这些录音被提供给了软件公司,最终被科技公司采购并商品化。

科技公司通过AI技术将殷女士的声音克隆为文本转语音产品“魔小璇”,并在软件平台上销售。殷女士认为此举侵犯了她的声音权益,将相关公司起诉至法院,要求停止侵权、赔礼道歉,并索赔经济损失和精神损失共计60万元。此案不仅是技术与法律的冲突,更是对AI技术应用伦理的深刻反思。声音克隆技术的发展,为语音合成、个性化服务等领域带来了便利,但同时也需要在法律框架内审慎应用,尊重和保护每个人的人格权。

本案的一个焦点是授权问题。被告认为AI化的声音不具有可识别性,不应纳入声音权益的保护范围。原告方认为,即使被告拥有关于著作权的授权,也不代表拥有人格权的授权。法院审理认为,如果社会公众能够根据音色、语调和发音风格关联到自然人,该声音即具有可识别性,应受保护。最终认定,被告文化传媒公司和软件公司未经原告许可使用其声音,构成侵权。

根据《中华人民共和国民法典》第一千零二十三条,自然人的声音权益参照适用肖像权保护的相关规定。声音权益属于人格权的一部分,其保护的前提是具有“可识别性”。

北京互联网法院副院长赵瑞罡指出,声音的标志性非常明晰,能够联想到一个人,因此声音权益是民法典新增加的一种标志性人格权。中国政法大学传播法研究中心副主任朱巍指出,声音权是参照肖像权予以保护的,通过声音识别特定人的权利属于具体人格权。专家认为,获得权利人的合法授权是判定声音权益侵权的关键。

2024年4月23日,北京互联网法院判决被告科技公司和软件公司向原告赔礼道歉,并由文化传媒公司和软件公司向原告赔偿经济损失25万元。法院的判决体现了对声音权益保护的重视,并对声音克隆技术的商业应用提出了法律要求。

个体的声音是在哪里被盗用?

声音克隆技术的发展为语音合成、个性化服务等领域带来了革命性的变化。然而,技术的双刃剑特性也使得基于声音克隆的诈骗活动日益增多。声音克隆也被不法分子用于实施诈骗,手法多样,日益猖獗。

基于AI技术克隆任何人的声音非常容易。只需要通过公开渠道提取语音样本,仅需要十几秒甚至秒钟的样本,就能制作出高度逼真的声音克隆。这些声音样本不仅能够模仿一个人的语调和语气,还能够复制其语言习惯和表达方式,使得接收者很难怀疑其真实性。

实施声音克隆新型电信网络诈骗前,诈骗分子首先会收集目标的信息,包含人像、联系方式、家庭住址、工作信息、生活信息等,受害人的照片、视频和声音。顶象防御云业务安全情报中心认为,这些信息的泄露途径多种多样。

1、社交媒体。由于社交媒体已成为人们日常生活中不可或缺的一部分,避免在社交媒体上过度分享敏感信息,由此成为诈骗分子获取诈骗素材的库房。

2、网络数据泄露。大规模的网络数据泄露事件可能导致个人信息被泄露,包括照片、视频和声音等。诈骗分子通过暗网平台,可以获取这些泄露的数据来实施诈骗活动。

3、网络钓鱼和恶意软件。诈骗分子通过发送钓鱼邮件或利用恶意软件来获取受害人的个人信息,包括照片和视频。一旦他们成功获取了受害人的设备访问权限,就可以进一步获取更多的个人资料。例如,2024年2月15日,国外安全公司Group-IB宣布,发现一个名为“GoldPickaxe”的恶意软件 。 该恶意软件的iOS版本,诱骗用户进行人脸识别、提交身份证件,然后基于用户的人脸信息进行“AI换脸”诈骗。

4、公开活动和活动现场。在包括会议、展会、社交活动等一些公共场所或特定活动中,诈骗分子可能搜集到受害人的照片、声音和视频。

面对声音克隆的挑战,技术专家和企业需要采取多层次的防护措施:一方面需要有效识别检测出伪造的声音,平台需要加强声音克隆的识别;另一方面防范声音克隆的利用和扩散,对使用者的行为和身份验证;从而有效降低攻击者的欺诈行为。其中,特别注意免在社交媒体上分享个人照片、声音和视频等敏感信息,减少公开个人账户、家庭、工作等私密信息,以降低身份被伪造的风险。一旦发现声音克隆的虚假内容,应立即向社交媒体管理员和执法部门报告,采取措施删除并追踪来源。

微信公众号

微信公众号 微信视频号

微信视频号